26/01/2017

Historia del SEO: la evolución que ayuda a entenderlo hoy en día

Por Pilar Carracelas Argiz @pilarcarracelas

Por Pilar Carracelas Argiz @pilarcarracelas

- Enlaces oficiales

- Wikipedia: Definición de SEO

- Wikipedia: Actualización Google Panda

El posicionamiento en buscadores (en inglés, SEO, de Search Engine Optimization, es decir, optimización para motores de búsqueda) ha cambiado mucho en los últimos años. Hemos pasado de un indexado rudimentario que permitía que los contenidos más visibles fueran los que aprovechaban mejor el algoritmo a su favor, y no necesariamente los más coincidentes con la búsqueda y más interesantes para los usuarios, a una época en la que se penaliza la sobreoptimización y el posicionamiento responde a una obsesión por el servicio al usuario.

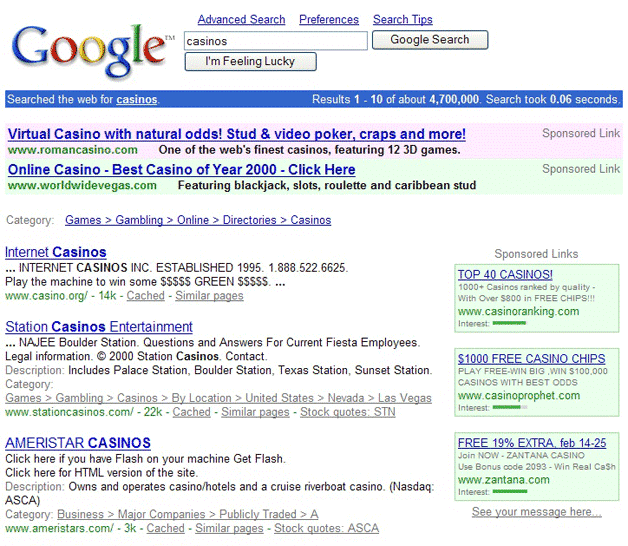

En esa etapa primitiva las webs que subían más posiciones en Google eran las que recibían más visitas globales, las que repetían más veces la palabra clave por la que querían subir posiciones y las que conseguían que más webs externas incluyeran links que apuntaran a la suya. Hoy, el SEO es algo vivo, que se adapta al día a día de los usuarios para ayudarlos a relacionarse más fácilmente con el mundo, con un proceso de indexado cada vez más parecido al criterio humano.

El SEO antes del SEO

Desde un punto de vista estricto, el SEO nació a partir de 1993 con la proliferación de las primeras páginas web (la primera apareció en 1991). En ese momento empezaron a hacerse necesarias plataformas que catalogasen la información que contenían las páginas web para poder encontrarlas con facilidad, como pasaba con el catálogo interno de una biblioteca, por ejemplo.

Una de estas primeras plataformas fue Excite, que fue pionera en facilitar esta búsqueda clasificando las páginas web basándose en palabras clave presentes en el contenido y la optimización del backend, es decir, de la programación (por aquél entonces no se diferenciaba front-end y back-end como hoy, sino que un diseñador gráfico hacía el diseño visual y un programador lo ejecutaba).

En seguida, los administradores de páginas web y proveedores de contenido empezaron a optimizar sus sitios web para aparecer en esos ránkings. Yahoo, que entró en escena en 1994, permitía a los sitios web solicitar su indexación en su buscador, que hacía de forma manual después de darse de alta. Con la aparición de otros buscadores como Altavista y Google en 1995 y 1997 respectivamente, los buscadores sofisticaron todavía más la recopilación de datos de las diferentes webs para clasificarlas en sus ránkings.

- Número de visitas.

- Número repeticiones de las palabras clave que los usuarios buscaban en los contenidos de la web.

- Backlinks, es decir, número de webs externas que referenciaban esa página con links a ella.

Inicios del SEO

Todo esto tenía su lógica. Con la tecnología disponible en aquél momento la manera de saber si una web coincidía con lo que el usuario buscaba era que esas palabras se repitieran, y de entre todas las webs que eran concordantes, la única manera que había de ordenarlas en el ránking por autoridad era medir las visitas que obtenía y que otras webs la referenciasen, de la misma manera que si en un libro citas a otro representa que ese otro es interesante. De esa forma, en ese momento era habitual que una web que cumpliera esos requisitos subiera en seguida de posiciones en buscadores.

Esto fue aprovechado por empresas que empezaron a concebir los usuarios como consumidores y potenciales clientes, y querían que sus contenidos aparecieran en estos buscadores por encima de su competencia cuando los usuarios hacían búsquedas relacionadas con los productos o servicios que ofrecían. Fue este, hacia los inicios de los años 2000, el momento en el que nació el SEO como hoy lo conocemos, como el aprovechamiento del algoritmo de los buscadores con fines comerciales.

La profesionalización del SEO

Resulta difícil saber si ocurrió antes que los motores de búsqueda se perfeccionaron y en consecuencia los usuarios empezaron a confiar en ellos para encontrar todo tipo de información, incluida la de productos y servicios que le interesaban, o si fue el aumento de búsquedas de todo tipo de información, incluida la de productos y servicios, la que provocó el perfeccionamiento de los motores de búsqueda.

La cuestión es que las empresas, no ajenas a esto, dedicaron su empeño en ser las primeras en aparecer en esas búsquedas, y eso fomentó que todavía más el uso de los buscadores por parte de los usuarios, al tener cada vez más variedad de resultados, y los esfuerzos de estos buscadores por mejorar su clasificación, al estar internet cada vez más repleto de páginas a indexar.

Uso excesivo de palabras clave (‘keyword stuffing’)

Se popularizaron los puestos de trabajo de copywriter que incurrían en prácticas de posicionamiento fraudulento, como el ‘keyword stuffing’ (recurrir a todo tipo de palabras clave y repetirlas más veces de lo necesario en un contenido, de manera que no resulta natural a la hora de leer, y en URLs y en metaetiquetas). De hecho, hace años había una etiqueta específica en la arquitectura web en la que se podían poner infinitas palabras clave, aunque no tuvieran que ver con el contenido de la página concreta.

Tráfico de backlinks

También se generalizó lo que podemos resumir en “sembrado y tráfico de links”, es decir, esparcir por todo tipo de foros, directorios y páginas web de baja calidad, que a menudo estaban pensadas para este efecto, links que apuntaban a la URL que se quería posicionar. También era habitual pactar con otras empresas que hacían lo mismo intercambios de links, es decir “tú me referencias a mí y yo te referencio a ti”, aunque las páginas no tuvieran nada que ver entre sí.

Esto, claro está, sin contar con otras prácticas más fraudulentas, como crear blogs con nuevas herramientas de fácil generación que iban surgiendo (Blogger, LiveJournal) supuestamente independientes de la empresa a propósito para colocar links o incluso poner texto del mismo color del fondo de una web para poner todavía más links y palabras clave. Durante este tiempo se popularizaron directorios, foros y páginas similares con el único propósito de poder listar links y palabras clave sin ningún tipo de servicio al usuario.

En este juego, claro está, las empresas más grandes tenían todas las de ganar, ya que podían permitirse tener un ejército de copywriters que invirtieran horas y horas en llevar a cabo estas prácticas que más tarde se denominaron ‘black hat SEO’.

Copia de contenidos

Otra práctica habitual fue la copia literal (o traducción directa si era en otro idioma) de contenidos entre páginas web. Mientras algunas lo hacían de forma más o menos inocente (por ejemplo, hay quien copiaba un párrafo de otra web para citar un contenido, como ocurre en un libro), otras copiaban de arriba a abajo contenidos (aunque citaran la fuente) aprovechándose de que sus webs tenían más autoridad y obtendrían más visibilidad que la web original.

No ser malvado

Para combatir estas prácticas que no premiaban a quienes generaban contenidos interesantes sino a quienes aplicaban técnicas SEO de forma más efectiva, Google tomó la iniciativa en el desarrollo de un campo de juego que diera más oportunidades a todos los actores para lograr una buena clasificación en su ránking. Esta motivación se veía reflejaba en su lema (que años más tarde desapareció, no queramos saber por qué), ‘Don’t be evil’ (“No seas malvado”), que buscaba regular los resultados de búsqueda para asegurarse de que las empresas obtuvieran sus resultados basándose en prácticas éticas, orientadas a ser útiles al usuario. Esto desbancó a los buscadores de la competencia (en 2003, Altavista quedó atrás y fue adquirida por Yahoo).

Entonces empezó una década de actualizaciones constantes en el algoritmo (Moz lista aquí una cronología de estas actualizaciones), encaminadas a evaluar cada vez más el valor y la relevancia de los resultados, personalizando los resultados basándose en el historial de búsquedas de los usuarios o en la ubicación del usuario con soporte como mapas, ubicaciones, horarios comerciales y resultados optimizados para teléfonos móviles.

En general, en este período se sentaron las bases para un internet más personalizado y centrado en el usuario.

Todo por el usuario

Esta evolución de las búsquedas y del comportamiento de los usuarios en internet (aquí la aparición y generalización de Facebook, Youtube y gestores para generar contenidos web -como Blogger, Drupal y más tarde WordPress- fueron cruciales), y su monitorización con nuevas herramientas como Google Analytics, requirieron una experiencia de búsqueda más reactiva, que visibilizara contenidos más atractivos en los resultados, como noticias, imágenes y videos (Google Search, Google Imágenes, Google Videos, Google News…).

Este enfoque del SEO orientado al usuario ayudó a sentar los cimientos de un internet más personalizado. En este punto la aparición del navegador propio de Google, Chrome, Google+ y otras aplicaciones, como Google Maps o Drive, fueron fundamentales para anticiparse a las intenciones del usuario y ofrecerle esa gratificación instantánea, así como más adelante lo fue la puesta en marcha de Android, el sistema operativo de móviles participado por Google. Las marcas debían tener todas estas premisas en cuenta para visibilizarse en internet.

El antes y el después de Panda

Entre 2010 y 2012 tuvieron lugar los cambios más drásticos del SEO hasta la fecha. El más importante fue el llamado Panda, cuyas actualizaciones se llevaron a cabo de manera periódica desde febrero de 2011 a julio de 2013, aunque en mayo de 2010 los webmasters ya notaron desplomes en los contenidos más breves y menos elaborados o copiados (lo que cotidianamente llamaríamos contenidos “pobres” o de baja calidad) en favor de otros inéditos, más extensos y trabajados, algo que provocó un aumento en el ranking de sitios web de noticias y de redes sociales, en detrimento de sitios web que basaban sus contenidos en publicidad. Las webs afectadas fueron más de un 20%.

Seguramente muchos habrán oído hablar del ERE que sufrió Softonic en 2014. Pues esta empresa que ofrecía software online sustentaba su negocio básicamente en los clientes que atraían gracias a su buena posición en Google, pero sus contenidos contienen grandes cantidades de publicidad, por lo que fueron enterrados en los resultados de búsqueda por debajo de otros considerados de más valor para el usuario, y eso les costó pérdidas de varias decenas de millones de euros en pocos meses.

A partir de entonces las marcas tuvieron que empezar a ganarse los resultados orgánicos de Google a pulso, a través de contenidos de calidad enfocados inequívocamente a servir al usuario, de lo contrario se enfrentaban a duras penalizaciones. Ni siquiera Amazon o Ebay se libraron de penalizaciones, teniendo que mejorar los contenidos y la experiencia de usuario de sus webs para posicionar sus páginas. Las prácticas de black hat de la empresa de venta por catálogo J.C. Penney y Overstock fueron duramente penalizadas para dar ejemplo, entre otras empresas.

Para optimizar una web, los expertos en márketing debían generar contenido enfocado al usuario, de elevado valor y compartible, con la ayuda de las redes sociales, que creaban backlinks valiosos y un compromiso que revestía la web de autoridad. Esta tendencia condujo al esplendor de la era de la información con la información rápida, personalizada e interesante que conocemos.

La actualidad del SEO

En la actualidad Google ha llevado la personalización y la usabilidad hasta el punto de poner en jaque la privacidad de los usuarios. Google aprovecha los datos que almacena para desarrollar su propia presencia digital por medio de la personalización basados en el historial de búsquedas, la ubicación del usuario y el dispositivo desde donde se conecta a internet. Sin embargo, las empresas que luchan por hacerse visibles no tienen acceso a esos datos y eso crea una paradoja que requiere un enfoque más creativo para generar compromiso en los usuarios a través de la optimización del contenido.

Las búsquedas desde móvil ganan protagonismo y el contenido relevante y accesible para móviles (como el contenido responsive -fácilmente consultable desde smartphones- y el que tiene en cuenta el tipo de público que hace una búsqueda y su intención) es especialmente valorado.

Esta obsesión por el usuario provoca que Google valore cada vez más los contenidos que cuentan con sus aportaciones, como las tiendas con valoraciones de productos, las reseñas, los posts, las noticias y en general los contenidos multiplataforma (con vídeos, imágenes de calidad e incluso elementos de gamificación), y por lo tanto deje en segundo lugar las páginas corporativas puras y duras. Tenderá a valorar más una página de reservas de peluquería que ofrezca la posibilidad de visualizar todas las peluquerías cercanas antes que una peluquería concreta, o una página con los diez mejores restaurantes de un lugar que un restaurante concreto de ese mismo sitio.

Evidentemente hoy se penaliza sobreoptimización, como el ‘keyword stuffing’, la copia de contenidos (incluida la copia por medio de la traducción de webs en otro idioma) y los backlinks que no están justificados con lo que se explica.

Por eso estas empresas deben buscar otras maneras, generalmente mixtas, de construirse una presencia en internet, como se explica en este artículo, siempre con la vista puesta en el usuario, como, al fin y al cabo eso es lo que han hecho las buenas empresas toda la vida. Surgirán nuevas formas de generar conversación que se deberán aprovechar para hacer más atractivo el sector de cada empresa, más que para vender propiamente, ya que el usuario hoy busca lo que quiere en mucha más medida que antes y no quiere que le invadan con publicidad.

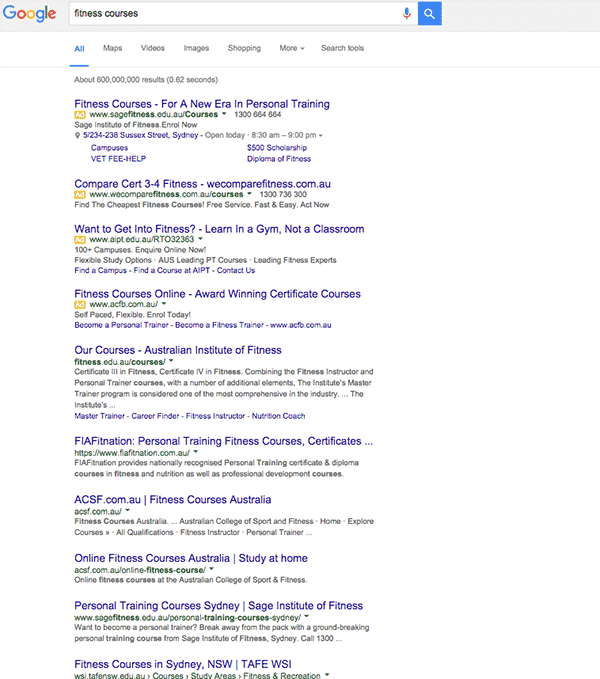

Optimización también en el SEM

Incluso los resultados patrocinados están cada vez más orientados al cliente. Han desaparecido los resultados patrocinados laterales en la página de resultados de Google y han aumentado hasta 4 los primeros resultados patrocinados, de manera que las empresas deberán esforzarse en hacer que anuncios y webs (porque de éstas últimas depende en gran medida que los anuncios aparezcan) sean tan relevantes y valiosos como los resultados orgánicos, y prepararse para un aumento del coste por click, al haber menos espacio para anuncios.

La optimización ya no será sólo para procurar un buen resultado en el ránking sino para procurar que el máximo de usuarios que aterrizan en la página lleven a cabo la acción que la empresa se plantea con la web (petición de contacto, suscripción, compartición de contenido, etc.) Los buenos tiempos para las mentes creativas están lejos de terminar.

Otros artículos relacionados

26/03/2017 (Search Engine Land)

La evolución de las tendencias de SEO a lo largo de más de 25 años26/03/2017 (Marketing Land)

10 grandes marcas que fueron penalizadas por Google26/03/2017 (El Periódico)

¿Qué es el SEO (y qué ya no es hoy en día)?26/03/2017 (Web Profits Blog)

Lo que necesitas saber sobre los cambios en los resultados de búsqueda de Google